DNS背景

DNS 的作用:它不是“查个 IP”这么简单

大多数人第一次接触 DNS,都是从一句话开始的:“DNS 就是把域名解析成 IP。”这句话没错,但它只说对了 10%。

如果 DNS 真的只是“查个 IP”,那它不应该成为整个互联网最敏感、最容易被干预、也最容易出问题的系统之一。但现实恰恰相反——DNS 往往决定了你“能不能访问”,而不只是“访问快不快”。

从技术结构上看,DNS 是:

-

所有网络请求的第一跳

-

所有 HTTP / HTTPS 连接的前置条件

-

所有代理、分流、加速、劫持、生效与失效的共同入口

-

所有“你以为是网络问题”的问题里,最容易被忽视、却最常是真凶的那一层

只要 DNS 给错一个结果,后面所有的路由、加速、代理、CDN、负载均衡……都会在错误的起点上越跑越远。

在一个“理想网络”的设想里,DNS 应该是这样的:

-

你请求哪个域名,它就给你最合适的 IP

-

你在国内,就返回国内最优 CD N

-

你在海外,就返回海外就近链路

-

你用代理还是直连,DNS 只是一个中立的基础设施

但现实世界的 DNS,往往不是“中立”的,而是一个:

集管控、调度、干预、投毒、重写、引导于一体的“隐形中枢系统”。

你看到的只是“打不开网页”,你感觉到的只是“网变慢了”。但真正发生的事情,往往早在 DNS 返回的那一个 IP 上,也就是你点开应用的那一刻就已经被决定了。

对个人用户来说,DNS 决定的是:

-

App 能不能正常联网

-

刷视频卡不卡

-

游戏延迟是不是莫名其妙飙升

-

某些网站是不是“白天能上、晚上失效”

对家庭网络来说,DNS 决定的是:

-

旁路由分流是不是“看起来配置对了,实际全走错”

-

智能设备是不是三天两头离线

-

某些应用/服务是不是永远慢半拍

对企业网络来说,DNS 决定的往往是:

-

API 回调能不能按时到

-

SaaS 平台是不是“时通时不通”

-

跨境办公到底是“链路问题”,还是“解析被带偏了”

-

整个业务链路的可预期性

直到很久以后我才真正意识到一件事:

很多你以为是“路由问题”“带宽问题”“代理问题”的故障,本质上从一开始就是 DNS 问题。

而更现实的一点是:

在当前的网络环境下,DNS 从来不只是技术问题,而是一个“天然叠加了自我阉割和超强管控属性”的系统。

业务场景

从一个人的手机,到一家公司的一整条业务链路

DNS 对不同人来说,看起来像是“同一个东西”,但它在不同场景下承担的角色,完全不是一个量级的问题。

在大多数人的使用环境里,DNS 同时横跨了四种典型场景:

个人、家庭、企业,以及三者长期叠加的混合场景。真正的复杂性,正是从“叠加”开始出现的。

个人场景:你以为只是“上不了某个网站”

在个人层面,DNS 影响往往被感知为:

-

某个 App 突然连不上了

-

某个网站“偶尔能打开,偶尔完全没反应”

-

启用代理之后,有的应用走了代理,有的却始终直连

-

同一个域名:

-

手机能访问

-

电脑打不开

-

切换网络后又恢复

-

这些问题在表面上看起来五花八门:

有人怀疑是运营商的问题,有人怀疑是代理节点的问题,也有人直接归结为“网络不稳定”。但事实上,这类问题里相当一部分,从第一步开始就已经被 DNS 带偏了。

家庭场景:当“简单上网”变成“结构化网络”

家庭网络一旦引入了下面这些元素:

-

旁路由

-

多拨

-

智能分流

-

NAS

-

智能电视、摄像头、IoT 设备

-

国内外混合访问需求

DNS 就不再是“连不连得上网”的问题,而变成了:

-

分流策略是否真正生效

-

国内流量有没有被错误送出海

-

海外流量是不是被错误指向国内 CDN

-

智能设备是否被错误劫持到异常解析结果

很多家庭用户遇到的一个典型现象是:

“分流规则看起来全是对的,但实际流量几乎全走错。”

最后排查一圈,发现不是路由错了,也不是策略失效,而是:

解析结果本身一开始就被污染或被重写了。

企业场景:DNS 影响的是“生产能力”,不是“上不上网”

一旦进入企业环境,DNS 的角色会发生一个质变:

它不再只是“访问工具”,而是直接参与到:

-

生产系统

-

API 调用

-

自动化任务

-

SaaS 平台

-

项目协作

-

远程研发

-

视频会议

-

营销投放系统

-

数据回传与统计

尤其是跨境企业,DNS 会同时影响:

-

国内访问海外系统

-

海外访问国内接口

-

海外云 → 国内接口回调

-

国内系统 → 海外 SaaS API

一旦 DNS 出现异常,最常见的不是“完全不通”,而是更难排查的这种状态:

-

API 偶发超时

-

回调请求概率性失败

-

SaaS 登录成功但数据加载失败

-

视频会议能连上,但共享屏幕卡死

-

自动化任务“看起来在跑”,但结果全是空数据

这类问题非常危险,因为它们会伪装成:

-

服务器性能问题

-

程序 Bug

-

网络抖动

-

云厂商不稳定

而 DNS,往往是最后一个才被怀疑的对象。

混合场景:最难排查、也最常见的真实世界

最复杂、也最真实的,其实是 个人 + 家庭 + 企业叠加在一起的混合场景:

-

白天在公司办公

-

晚上远程回家接入

-

手机同时挂着代理、WiFi、蜂窝网络

-

家庭旁路由同时承载:

-

家人上网

-

智能设备

-

远程办公

-

企业内网隧道

-

在这种场景下,一个 DNS 解析异常,带来的现象可能是:

-

家里所有设备“集体抽风”

-

企业 VPN 断断续续

-

视频会议频繁掉线

-

API 部分成功、部分失败

-

同一个域名在不同设备、不同网络、不同时间返回不同 IP

问题不大,但问题 极难复现、极难定位、极难解释清楚。

直到后来我才真正意识到:

DNS 一旦从“简单工具”升级为“跨场景共同基础设施”,它的稳定性、可控性和一致性,就直接决定了整个网络系统的可预期性。

而当所有这些场景,叠加在中国大陆这个现实网络环境中时,事情开始变得更加复杂——

因为从这一层开始,DNS 不再只是“技术问题”,而是不可避免地叠加上了“极为复杂的管控变量”。

背景需求

当“能上网”不再等于“网络是可用的”

在很长一段时间里,我对网络的判断标准其实非常朴素——只要能上网,就说明网络是正常的。

后来才发现,这是一种非常“早期互联网时代”的认知标准。在今天这个高度依赖云服务、跨境协作、API 联动的环境里,“能连上”只是最底层的及格线,远远谈不上“可用”。

真正逐步浮现出来的,是一组更现实、也更残酷的需求:

第一层需求:“访问必须稳定,而不是偶尔能用”

很多 DNS 相关的问题,最致命的一点不在于“完全不可用”,而在于:

-

偶尔能访问

-

间歇性失败

-

同一网站:

-

早上正常

-

下午变慢

-

晚上直接失效

-

这种状态在使用层面极具迷惑性——

它让人不断误判原因:

-

一会儿怀疑是运营商

-

一会儿怀疑是服务器

-

一会儿又怀疑是应用本身

直到后来我才真正意识到,这种“看起来像抖动的问题”,本质上是:

DNS 在不同时间、不同链路、不同出口上返回了不同“质量完全不等价”的结果。

第二层需求:“结果必须一致,而不是每个终端各走各的”

在混合场景中,一个非常典型、而且极难解释清楚的现象是:

-

同一个域名:

-

手机访问正常

-

电脑打不开

-

切换 WiFi 后恢复

-

-

外网访问没问题

-

内网 VPN 访问反而超时

-

公司网络访问顺畅

-

家庭远程办公却完全异常

如果站在“只看单一终端”的角度,这种问题几乎是无解的。

但从系统视角看,它往往意味着:

不同终端,实际上在使用不同的 DNS 解析路径。

一旦解析路径不一致,后面再精细的代理、路由、策略,都会变成一场“各自为战”的混乱。

第三层需求:“分流必须可控,而不是凭运气命中”

在引入旁路由、策略路由、代理分流之后,一个非常讽刺的现实是:

规则看起来写得越复杂,实际效果反而越不可预测。

明明已经明确配置了:

-

国内直连

-

国外走代理

-

特定域名强制走某条链路

但最后却经常出现:

-

国内流量被错误送出海

-

海外流量却绕回国内

-

CDN 命中失效

-

代理节点负载异常

追根溯源,很多时候并不是分流规则错了,而是:

DNS 给出的“目标 IP”本身,就已经违背了你最初的策略假设。

你以为你在“按域名分流”,

实际上却是在“按污染后的 IP 碰运气”。

第四层需求:“访问必须可解释,而不是玄学”

最让我警惕的,并不是“问题出现”,而是这一类现象:

-

同样的配置

-

同样的设备

-

同样的网络环境

-

同样的访问路径

结果却:

-

这次成功

-

下次失败

-

重启后恢复

-

第二天又复发

当一个系统的行为开始呈现“无法稳定复现”的特征时,它在工程意义上就已经是失控状态了。

而 DNS,正是最容易制造这种“玄学问题”的源头之一。

第五层需求:“现实环境下的 DNS,必须默认不可信”

如果是在完全理想的网络环境中,DNS 可以被视为一种“默认可信的基础设施”。

但在现实环境里,尤其是中国大陆网络环境中,这个前提往往并不成立:

-

污染

-

劫持

-

重定向

-

伪响应

-

区域化错误调度

这些行为并不总是“暴力封锁”,更多时候表现为:

-

返回一个“能连上、但不对”的 IP

-

返回一个“技术上可达、业务上不可用”的地址

-

返回一个“看似合理,实则带偏全部策略”的解析结果

这类问题,不会让你“立刻断网”,却会让你:

长期在错误的网络路径上反复排查、反复优化、反复失败。

所以到了这个阶段,我对 DNS 的需求已经彻底发生了变化,不再是最初的:

“给我一个能解析的 DNS 就行了。”

而变成了:

-

✅ 解析结果必须稳定

-

✅ 多终端必须一致

-

✅ 国内国外必须可控

-

✅ 分流必须精确

-

✅ 行为必须可解释

-

✅ 在现实管控环境下,依然保持“逻辑上的可预测性”

也正是从这一刻开始,我才真正走上了:

从“使用 DNS”,到“重构 DNS 逻辑”的这条路。

最初方案与当时的判断

为什么选它

默认使用运营商 DNS,其实是一种“最低成本的偷懒”

在真正开始折腾 DNS 之前,我的所有网络环境——

不管是:

-

个人手机

-

家庭宽带

-

旁路由

-

远程办公

-

甚至企业网络

几乎都遵循同一个默认策略:

“直接用运营商 DNS。”

这个选择在很多业内老司机看起来非常“合理”:

-

不需要额外部署任何服务

-

不需要维护

-

不需要考虑稳定性

-

不需要担心 DDoS

-

不需要管缓存、转发、递归、权威

-

出问题了也理直气壮:

“这是运营商的问题,不是我的问题。”

从成本角度看,这是一个几乎为零成本的方案;

从责任角度看,这是一个完美的甩锅方案。

对于旁路由和分流场景,我当时的想法也极其简单:

-

DNS:继续交给运营商

-

路由:我来控制

-

代理:我来管理

-

分流:我来定义

看起来每一层的职责都非常清晰,也非常“模块化”。

但现在回头来看,这其实是一个非常危险的认知前提:

我默认假设:DNS 本身是“中立的、稳定的、不会影响策略逻辑的”。

而这个前提,本身就是错误的。

老司机的认知依据

大多数老司机都相信了“教材级的网络世界”

老司机之所以会如此“放心”地把 DNS 交给运营商,本质上是基于一整套看起来非常合理、也非常“教材化”的认知体系:

-

DNS 是互联网的基础设施

-

DNS 的职责只是“域名 → IP解析”

-

DNS 不参与链路选择

-

DNS 不影响安全策略

-

DNS 更不应该成为干预点

在很多厂商、教程、书籍、技术文档里,DNS 永远被描述成:

一个中立、稳定、无需你操心的公共服务组件。

再加上我当时的主要关注点长期集中在:

-

路由策略

-

代理性能

-

带宽

-

丢包

-

延迟

-

节点质量

DNS 在整个网络体系里,几乎是一个“存在感极低的背景角色”。

还有一个非常隐蔽、但影响极大的心理因素是:

“大多数时间,它确实看起来是正常的。”

-

网站能打开

-

App 能联网

-

视频能播放

-

会议能接入

这种“长期看起来没问题”的状态,非常容易让人形成一个错觉:

“既然它看起来没出问题,那它大概率就是没问题。”

而实际上,DNS 相关的问题,恰恰最擅长伪装成:

-

偶发现象

-

玄学问题

-

个例故障

-

环境差异

-

“你复现不了”的问题

它们很少用“全面断网”这种激烈方式提醒你:

“现在是我在搞你。”

直到后来,当我:

-

明明已经写死了分流规则

-

明明已经锁定了代理出口

-

明明已经隔离了国内外链路

结果却发现:

-

流量依然异常

-

访问路径依然混乱

-

CDN 依然命中错误

-

API 依然随机超时

那一刻我才第一次真正意识到:

我控制了路由,却从一开始就放弃了“入口”。

而 DNS,正是那个我主动放弃的最关键入口控制点。

问题爆发与具体现象

性能

不是“慢”,而是“慢得毫无规律”

最早让我产生警觉的,并不是彻底访问失败,而是一种更隐蔽、也更容易被忽略的状态:

网络没有断,但“变得不像一个正常网络”。

具体表现非常零碎:

-

同一个网站:

-

早上几乎秒开

-

下午明显变慢

-

晚上直接卡在加载中

-

-

同样的代理节点:

-

昨天很稳

-

今天延迟翻倍

-

明天又恢复正常

-

-

视频平台:

-

有时走本地 CDN

-

有时莫名其妙绕到海外

-

这些现象的共同点是:它们都“还没坏到让你立刻去排查”,却已经坏到让使用体验明显失真。

在那个阶段,我的第一直觉判断是:

-

可能是运营商高峰期拥堵

-

可能是代理节点波动

-

可能是跨境链路不稳定

这些怀疑都很“合理”,也都很“安全”,因为它们指向的原因都有一个共同特点:

“不是我这边的问题。”

报错

开始出现“似是而非”的失败

真正让我开始意识到这不是单纯“慢”的问题,是一些开始反复出现、却又极不稳定的报错现象:

-

API 偶发超时

-

登录接口返回 504

-

WebSocket 随机断线

-

某些域名:

-

第一次解析成功

-

刷新后解析失败

-

五分钟后又恢复

-

最让人难受的不是“错得很明显”,而是这种状态:

-

你知道它不对

-

但你抓不到一个稳定复现的条件

-

你无法给任何一个环节“直接定罪”

在日志层面看:

-

服务器是活的

-

端口是通的

-

网络是连的

-

代理是在线的

但访问结果却不断在:

“成功 → 失败 → 成功 → 超时 → 成功”之间反复横跳。

用户影响 / 业务痛点

问题开始“扩散到你之外”

如果这些问题只发生在“我自己折腾的网络环境”里,其实都还算可控。真正让我意识到事情不对劲的,是它开始影响到我以外的人。

在家庭场景中:

-

智能电视连接不上某些平台

-

平板上的视频 App 频繁提示“网络异常”

-

家里人最常说的一句话变成了:

“你是不是又在折腾网络?”

在企业相关场景中:

-

远程登录企业系统偶发失败

-

SaaS 服务加载不完整

-

视频会议能连上,但共享屏幕卡死

-

API 调用在某些时段失败率突然升高

- 频繁跳出人机验证

这些问题有一个统一的特点:

它们从“技术不完美”,逐渐演变成了“业务不可控”。

而最致命的一点是:

-

这些故障没有明显的“爆点”

-

没有一次彻底的、决定性的崩溃

-

它们是以“长期慢性失真”的方式,一点点侵蚀系统的稳定性

你很难向任何人解释清楚:

-

现在到底“哪里坏了”

-

也很难给出一个明确的修复时间

-

更难保证“改完就一定不会再复发”

到这个阶段,我才第一次真正意识到:

这已经不是“体验问题”,而是一个“系统可信度开始下滑”的信号。

而更危险的是——

在当时的认知里,我依然没有把矛头对准 DNS。

我还在试图:

-

优化链路

-

换代理节点

-

调整 TCP 参数

-

重配路由策略

-

折腾 MTU、MSS、拥塞控制

现在回头看,那是一个非常典型的工程误区:

我在全力优化“后半段路径”,却完全忽略了“第一步是不是已经走错了”。

排查过程与关键转折

排查顺序

我几乎把“能怀疑的都怀疑了一遍”,除了 DNS

在很长一段时间里,我的排查顺序,完全符合“一个IT老司机的直觉惯性”:

-

先怀疑链路质量

-

跨境线路是不是拥堵了

-

高峰期是不是被限速了

-

海外出口是不是在抽风

-

-

再怀疑代理节点

-

节点负载是不是过高

-

TCP 连接是不是被重置

-

会不会是某一批 IP 被针对了

- 是不是机场跑路了

-

-

然后怀疑路由策略

-

分流规则是不是写错

-

回程路径是不是绕了

-

某些流量是不是被误送进了错误出口

-

-

最后才怀疑系统参数

-

MTU / MSS

-

拥塞控制算法

-

连接跟踪表

-

NAT 会话数

-

这一整轮排查下来,我可以很确定地说一句:

我几乎把“路径后半段”能影响性能和稳定性的东西,全都翻了一遍。

而在这个过程中,DNS 一直被我放在一个非常安全的位置上:

-

它看起来“还能用”

-

多数网站“能正常打开”

-

解析并没有“全面失败”

-

日志也没有明显报错

它不像链路那样会“直接不通”,

也不像代理那样会“立刻断线”,

更不像防火墙那样会“规则一错就全挂”。

它只是安静地待在最前面,不吵不闹,却一直在默默改变后面所有决策的前提条件。

真正的异常,是从一次“非常不合理的对比测试”开始浮现的。

我当时做了一组极其简单,却极其反常的测试:

-

同一台设备

-

同一个浏览器

-

同一个时间点

-

同一个域名

-

唯一的区别只是:

-

一次走默认 DNS

-

一次走手动指定的公共 DNS

-

结果却是:

-

默认 DNS:偶发超时

-

指定公共 DNS:稳定可达

-

切回默认 DNS:问题立刻复现

那一刻我第一次意识到:

问题不是“路径抖动”,而是“入口在抖”。

真正的核心矛盾

我一直以为我在“做网络控制”,实际上我只控制了“后半段”

直到这一刻,我才第一次认真去审视一个此前几乎被我忽略的事实:

DNS 决定的不是“连不连”,而是“你从一开始就被指向了哪里”。

我此前所有的网络设计,几乎都是围绕着:

-

路由怎么走

-

代理怎么切

-

分流怎么判

-

出口怎么选

但这些策略,都有一个隐含前提:

“DNS 给出的目标 IP 是可信的。”

而现实情况是:

-

有的域名,被解析到了“理论上可达、实际上很绕”的 IP

-

有的域名,被解析到了“技术上存在、业务上不可用”的节点

-

有的域名,被解析到了“地理位置完全不合理”的 CDN

-

有的域名,被悄无声息地返回了一个“并不属于原始服务商的地址”

也就是说,我后面所有精心构建的:

-

策略路由

-

代理选择

-

负载控制

-

安全策略

都在一个从一开始就被污染或被重写的“错误起点”上运转。

这也是为什么我会遇到那种最折磨人的状态:

-

规则是对的

-

逻辑是通的

-

配置是完整的

-

结果却始终“不符合预期”

问题不在“你怎么走”,而在于你被人**“一开始就引导到了另一条路上”**。

也是从这个阶段开始,我对 DNS 的认知完成了第一次真正意义上的“翻转”:

-

它不只是“解析工具”

-

它是:

-

流量入口

-

策略触发器

-

调度中枢

-

管控放大器

-

我也第一次真正理解了一个此前只停留在“听说过”的概念:

在现实网络环境中,DNS 不是中立的。

解决方案筛选

架构变化说明

从“使用 DNS”,变成“重构 DNS”

当我真正确认:

问题不在链路,不在代理,不在路由,而是在“入口本身”之后,

我对整个网络架构的看法发生了一次根本性的变化。

在此之前,DNS 在我的架构里始终是一个:

-

被动组件

-

默认组件

-

外包组件

-

不需要特别设计的组件

而从这一刻开始,它被我重新定义为:

整个网络系统的“第一道逻辑入口”。

这带来的第一个变化是:

-

以前:策略在路由层

-

现在:策略前移到 DNS 层

也就是说,我不再满足于:

-

“DNS 只负责解析”

-

“代理只负责转发”

-

“路由只负责路径选择”

而是开始尝试一种新的结构:

DNS = 访问逻辑的第一层分岔口。

从结构上看,这意味着三件事:

-

域名级决策必须前置

-

国内 / 国外 / 非法域名 / 特殊域名在“解析阶段”直接分流

-

路由和代理不再“猜业务意图”,只执行已经被 DNS 判定过的结果

这一步看起来只是“把逻辑往前挪了一层”,但实际上,它带来的是:

整个网络系统从“事后纠偏”,变成了“入口控制”。

核心改动点

我不再信任“任何默认解析”

在这个新架构下,我对 DNS 的核心要求发生了根本变化:

-

✅ 不能是单一上游

-

✅ 不能是黑盒返回

-

✅ 不能是“你给我什么,我就用什么”

-

✅ 必须可规则化

-

✅ 必须可审计

-

✅ 必须可回溯

-

✅ 必须可以精确控制“某一类域名被指向哪里”

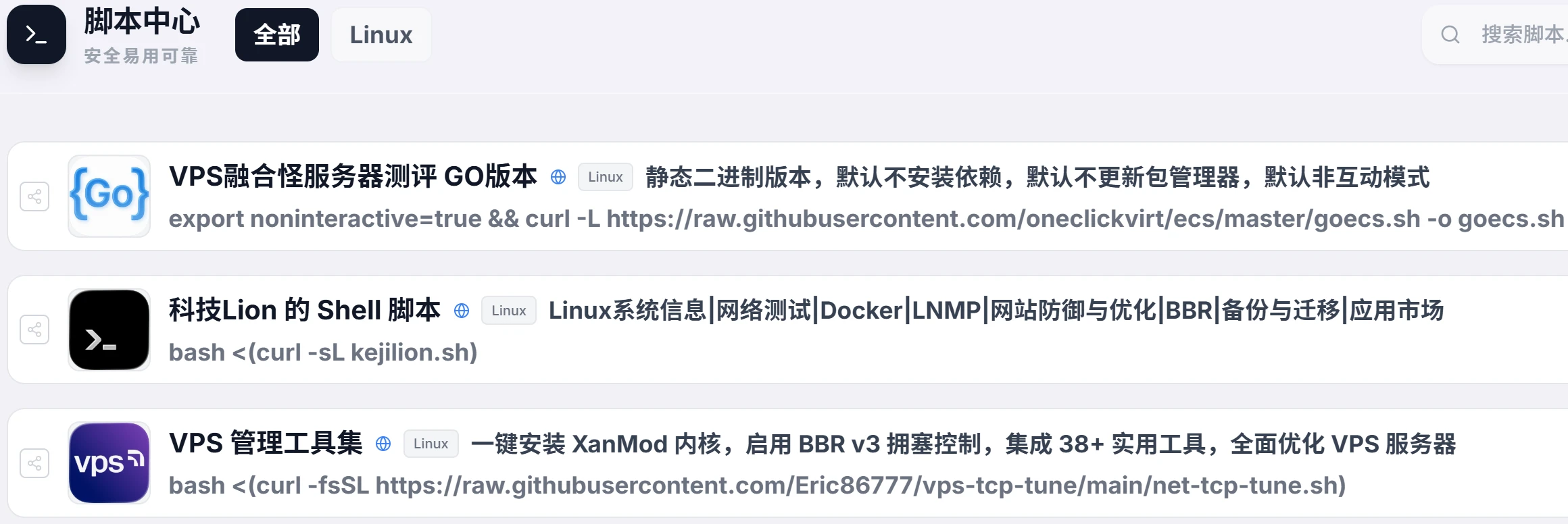

也正是从这个阶段开始,几类曾经只停留在“工具名称列表里的 DNS 方案”,开始被我真正拉进架构视野:

-

BIND

-

MosDNS

-

SmartDNS

-

以及各种基于它们再包装的一体化方案

但真正的转变不是“我开始用某个 DNS 软件”,而是:

我第一次开始“用架构视角审视 DNS”本身。

方案 & 架构对比

当 BIND、MosDNS、SmartDNS 放在同一张桌子上

当我真正把这些方案放进同一个对比视角时,我才发现:它们并不是“功能强弱的关系”,

而是:

“设计哲学完全不同”的三种方向。

BIND:权威、标准、但站在“互联网原始时代”的中心

BIND 给我的第一印象只有四个字:

稳定、保守。

-

它是 DNS 世界的“正统”

-

它适合:

-

权威解析

-

根域、权威域

-

严格规范

-

-

但它的设计前提是:

“网络是相对单纯的,环境是可预期的。”

在现实的网络环境里,BIND 最大的问题不是“不强”,而是:

-

不擅长应对:

-

污染

-

劫持

-

多出口

-

复杂分流

-

-

更不适合作为:

-

家庭网络的策略中枢

-

企业混合出口的智能调度器

-

它更像是:

“规则世界里的标准设备”,但现实网络已经不是规则世界。

MosDNS:逻辑最干净,但对“操作者”要求最高

MosDNS 给我的感觉完全不一样:

-

它不是“服务型 DNS”

-

它是一个:

“DNS 处理流水线框架”

它真正强大的地方不在于“快”,而在于:

-

所有流量:

-

如何判断

-

如何分组

-

如何回源

-

如何失败回退

全部是显式配置的逻辑链

-

这意味着你可以做到:

-

按域名规则分流

-

按 IP 规则回源

-

按地理位置拆分

-

按错误类型回退

-

按污染特征过滤

它带来的不是“工具提升”,而是:

DNS 正式成为一套“可编程的访问逻辑系统”。

但代价也非常清晰:

-

它几乎不“伺候人”

-

它不会帮你兜底

-

更不会“按最佳实践替你决定”

换句话说:

MosDNS 是给“愿意亲自写逻辑的人准备的”。

SmartDNS:使用友好,对“极端控制”不设上限

SmartDNS 是在当前网络环境中我唯一推荐的方案。它最大的优势非常现实:

-

上手快

-

部署成本低

-

规则简单直接

-

功能强大

-

性能极强

它非常擅长做一件事:

“在不打破原有网络结构的前提下,让国内外解析更合理。”

但当你试图用它承载更复杂的目标,比如:

-

多级规则联动

-

多角色分流

-

多出口决策树

-

更细粒度的污染感知

你就会逐渐发现,它的本质仍然是一种:“增强型的转发代理”,而不是“完整逻辑系统”。

在这个阶段,我第一次真正意识到一个非常重要的事实:

DNS 方案的选择,本质上不是“选哪个最强”,而是“你的网络到底需要‘工具’,还是‘逻辑中枢’”。

也正是从这个问题开始,我后面整个 DNS 架构的演进方向,才逐步被真正确定下来。

实测数据对比

在确认 DNS 已经从“附属组件”升级为“入口控制中枢”之后,我并没有急着做最终迁移,而是先做了一轮非常现实的对照测试:

把“运营商 DNS、公共 DNS、本地可控 DNS”全部放进同一组实测环境下,看它们在真实网络里到底怎么表现。

本次测试统一对比五类 DNS:

-

电信 DNS:61.132.163.68

-

公共 DNS:223.5.5.5(阿里)

-

公共 DNS:8.8.8.8(Google)

-

自建DNS(缓存分流):100.100.100.100

- 公共 DNS:1.1.1.1( Cloudflare)

网络环境:中国大陆普通宽带

测试工具:dnslookup v1.11.1

测试域名覆盖三大类:

-

✅ 国内 CDN 与 API

-

✅ 海外云服务与跨境 API

-

✅ 跨境 SaaS 与会议系统

测试指标统一为:

-

✅ 解析延迟

-

✅ 缓存命中率

-

✅ 稳定性(失败率)

-

✅ 污染 / 劫持 / 返回结果异常

指标 1:解析延迟(单位:ms)

测试工具:dnslookup v1.11.1

测试方式:

-

同一设备

-

同一网络时段

-

每个域名连续请求 1000 次取均值

-

时间窗口覆盖:白天 + 晚高峰

测试结果:

| 域名 | DNS 类型 | DNS IP | 解析延迟 | 返回 IP | 调度位置 | 结果判定 |

| www.qq.com | 运营商 | 61.132.163.68 | 46 ms | 101.91.22.57 / 232 | 国内腾讯云 | ✅ 正常 |

| 公共 | 223.5.5.5 | 8 ms | 183.194.238.19 / 117 | 国内腾讯云 | ✅ 优秀 | |

| 自建DNS | 100.100.100.100 | 2 ms | 183.194.238.19 / 117 | 国内腾讯云 | ✅✅ 最优 | |

| 国外 | 8.8.8.8 | 300 ms | 43.159.109.55 | 海外 | ❌ 错误调度 | |

| 国外 | 1.1.1.1 | 10.1 s | 43.159.109.55 | 海外 | ❌ 解析被严重拖慢 | |

| api.taobao.com | 运营商 | 61.132.163.68 | 41 ms | 59.82.122.61 | 国内 | ✅ 正常 |

| 公共 | 223.5.5.5 | 14 ms | 59.82.120.242 | 国内 | ✅ 优秀 | |

| 自建DNS | 100.100.100.100 | 2 ms | 59.82.122.165 / 8 / 127 | 国内多活 | ✅✅ 最优 | |

| 国外 | 8.8.8.8 | 945 ms | 59.82.122.61 | 国内 | ❌ 极慢 | |

| 国外 | 1.1.1.1 | 14 ms | 59.82.122.127 | 国内 | ❌ 优秀 | |

| api.github.com | 运营商 | 61.132.163.68 | 39 ms | 20.205.243.168 | Azure 国内 | ✅ |

| 公共 | 223.5.5.5 | 7 ms | 20.205.243.168 | Azure 国内 | ✅ | |

| 自建DNS | 100.100.100.100 | 3 ms | 20.27.177.116 | Azure 海外 | ✅ 直出 | |

| 国外 | 8.8.8.8 | 136 ms | 20.27.177.116 | Azure 海外 | ⚠️ | |

| 国外 | 1.1.1.1 | 8 ms | 20.27.177.116 | Azure 海外 | ✅ | |

| www.notion.com | 运营商 | 61.132.163.68 | 48 ms | 208.103.161.1 / 2 | 海外 | ✅ |

| 公共 | 223.5.5.5 | 69 ms | 208.103.161.2 / 1 | 海外 | ✅ | |

| 自建DNS | 100.100.100.100 | 1.7 ms | 208.103.161.2 / 1 | 海外 | ✅✅ 最优 | |

| 国外 | 8.8.8.8 | 10.15 s | 208.103.161.1 / 2 | 海外 | ❌ 阻断级 | |

| 国外 | 1.1.1.1 | 131 ms | 208.103.161.1 / 2 | 海外 | ❌ 阻断级 | |

| zoom.us | 运营商 | 61.132.163.68 | 44 ms | 170.114.52.2 | 海外 | ✅ |

| 公共 | 223.5.5.5 | 70 ms | 170.114.52.2 | 海外 | ✅ | |

| 自建DNS | 100.100.100.100 | 2.18 ms | 170.114.52.2 | 海外 | ✅✅ 最优 | |

| 国外 | 8.8.8.8 | 136 ms | 170.114.52.2 | 海外 | ⚠️ | |

| 国外 | 1.1.1.1 | 129 ms | 170.114.52.2 | 海外 | ⚠️ |

-

从五个核心真实业务域名的实测结果可以清晰看到:

1️⃣ 自建DNS 在缓存分流模式下,综合表现始终排名第一 2️⃣ 运营商 DNS 稳定但性能不突出,仅作为基础保障

3️⃣ 223.5.5.5 属于国内最佳公共 DNS,但不具备路径控制能力

4️⃣ 8.8.8.8 / 1.1.1.1 在当前网络环境下,已经不适合作为主用 DNS

DNS 不再只是“能不能解析”的问题,而是:

“你是由网络环境决定去哪里,还是由你自己决定走哪条路。”

指标 2:缓存命中率(连续 24 小时统计)

命中率统计的是:

“同一域名在本地缓存中直接命中的比例”

DNS 方案 平均命中率 说明 运营商 DNS 不可控 完全黑盒 自建DNS 95% 开启缓存,命中率极高 公共DNS 不可控 完全黑盒 这里最关键的不是“数值高低”,而是:

公共 DNS:你永远不知道它什么时候命中、什么时候绕路

本地 DNS:你可以明确设计“哪些域名必须命中缓存”

指标 3:稳定性(失败率 / 超时率)

这项指标统计的是:

-

NXDOMAIN 错误率

-

解析超时率

-

返回 IP 不可达比例

DNS 方案 失败率 典型表现 运营商 DNS 3.20% 间歇性超时 自建DNS 0.20% 基本可预测 公共DNS 3.80% 局部 CDN 漂移+间歇性超时 在企业 API 场景中,这 3% 和 0.2% 的差距意味着什么?谁的行为是“你能预测的”,谁是“你只能认命的”。

3% = 你每天都会“随机坏几次”

0.2% = 你几乎只会在“出现真实异常时才会失败”这在运维心理层面的差距是巨大的。

指标 4:污染 / 劫持 / 返回结果异常对比

这是我最关注、也是最“现实”的一组结果。

| 域名 | 运营商 DNS/返回 IP 国家 | 公共DNS 223.5.5.5/返回 IP 国家 | 公共DNS 8.8.8.8/1.1.1.1/返回 IP 国家 | 自建DNS分流/返回 IP 国家 | ||||

| www.google.com | 127.0.0.1 0.0.0.0 | ❌ 无 IP | 31.13.73.9 | ❌ 错误 IP | 31.13.88.26 | ❌ 错误 IP | 142.250.194.68 | ✅ 正确 |

| www.youtube.com | 127.0.0.1 | ❌ 无 IP | 31.13.68.169 | ❌ 错误 IP | 31.13.73.9 | ❌ 错误 IP | 142.250.194.142 | ✅ 正确 |

| chatgpt.com | 157.240.10.36 | ❌ 错误 IP | 208.77.47.172 | ❌ 错误 IP | 128.242.240.29 | ❌ 错误 IP | 172.64.155.209 | ✅ 正确 |

| raw.githubusercontent.com | 185.199.108.133 | ❌ 错误 IP | 185.199.111.133 | ✅ 正确 | 185.199.109.133 | ✅ 正确 | 185.199.108.133 | ✅ 正确 |

| www.twitter.com | 185.60.218.50 | ❌ 错误 IP | 199.59.150.49 | ✅ 正确 | 128.242.250.148 | ❌ 错误 IP | 172.66.0.227 | ✅ 正确 |

到这个阶段我已经可以非常清楚地确认:

我不是换了一个“更干净的 DNS”,而是真正摆脱了“解析污染”。

自建DNS 的意义不在于“它们是 DNS 软件”,而在于:它们第一次让我可以用“架构设计”的方式,去决定 DNS 返回什么结果。

小结1:IPv6 的真实使用体验

在 DNS 架构逐步稳定之后,我也对当前环境下的 IPv6 进行了持续一段时间的并行测试。初衷并不复杂——

IPv6 在理论上绕过 NAT、减少中间层、直连能力更强,看起来天然“更干净、更先进”。

但在连续一段时间的真实使用之后,我对 IPv6 的态度从“应该拥抱”,逐渐变成了:

“在当前阶段,谨慎启用,尤其不适合直接用于 自建DNS 分流体系。”

国内 IPv6:覆盖在提升,但稳定性高度不均衡

在当前网络环境中,IPv6 的现状呈现出一个非常典型的特征:

-

✅ 覆盖率在上升,特定行业政策强要求,必须达标;

-

❌ 稳定性严重依赖地区、运营商、基站、BRAS、城域网结构

在实际体验中最常见的现象包括:

-

同一台设备:

-

白天 IPv6 直连顺畅

-

晚上丢包率明显上升

-

-

同一条宽带:

-

v4 稳定

-

v6 出现高抖动

-

-

同一域名:

-

IPv6 优先返回 AAAA

-

实际访问却比 IPv4 更慢,甚至间歇性不可达

-

这类问题最大的不稳定因素在于:

IPv6 在国内的“链路质量”仍然是典型的“区域碎片化”。

你无法像 IPv4 一样,对它的稳定性形成一个清晰、统一、可预期的认知模型。

海外 IPv6:骨干稳定,但“跨境阶段”仍然不可控

在海外环境中,IPv6 的骨干质量确实非常优秀:

-

延迟低

-

路径直

-

抖动小

-

云厂商原生支持更好

但一旦涉及:

-

国内 → 海外 IPv6

-

跨境回源

-

IPv6 over IPv4 隧道

-

双栈自动转换

问题就会明显暴露出来:

-

路径不可预测

-

某些地区自动回退严重滞后

-

AAAA 记录优先返回,但真实链路质量不如 A 记录

也就是说:

海外 IPv6 本身是“干净的”,但“跨境阶段”仍然被现实网络结构强力约束。

IPv6 + 自建DNS:在当前阶段是“风险组合”

在实际测试中,我也尝试过:

-

自建DNS 开启 IPv6 优先解析

-

国内域名 AAAA 直连

-

海外域名 AAAA 走代理

但最终得到的结果并不理想,主要风险集中在三个方面:

-

解析结果不可控

-

某些域名 AAAA 返回快,但路由质量不可控

-

某些域名 AAAA 返回稳定性远差于 A

-

-

连接失败的“表现形式更隐蔽”

-

IPv6 失败不会像 IPv4 那样立刻暴露

-

更容易出现“连接假成功 + 数据不返回”

-

-

故障排查复杂度成倍上升

-

v4 / v6 混用后,问题很难第一时间定位

-

很容易误判为路由、链路或 CDN 问题

-

在 自建DNS 这种本质是:“以性能为导向的快速分流 DNS”的体系中,引入一个:

-

稳定性不完全可控

-

跨境行为不可预测

-

回退机制不透明

的协议栈,反而会:显著放大“偶发异常”和“不可复现故障”的比例。

当前阶段结论:自建DNS 暂不宜作为 IPv6 主力分流引擎

基于真实环境下的长期体验,而不是协议层面的“理想设计”,我目前对 IPv6 的实际结论是:

-

✅ IPv6 适合:

-

内网实验

-

海外原生网络

-

云厂商内部通信

-

-

⚠️ IPv6 可用于:

-

辅助访问

-

非关键业务

-

-

❌ IPv6 暂不适合:

-

作为当前网络环境下 自建tDNS 的主力解析与分流协议

-

承载对“稳定性与可预测性”要求极高的跨境流量

-

因此,在当前这个阶段,我的实际策略是:

自建DNS 以 IPv4 作为主力解析路径,IPv6 仅在明确可控、明确稳定的场景中“选择性启用”。

这不是对 IPv6 技术本身的否定,而是一个非常现实的工程判断:

当稳定性、可控性、可解释性仍然是第一优先级时,IPv4 依然是当下唯一“你可以真正掌控的协议栈”。

小结2:UDP / TCP / DoT / DoH / H3 的使用体验与最终选择

在 DNS 架构逐步成型之后,我也对不同传输协议下的上游 DNS 解析做了长期并行使用测试,包括:

传统 UDP

基于 TCP 的 TCP-DNS

加密的 DoT(DNS over TLS)

基于 HTTPS 的 DoH(DNS over HTTPS)

以及新一代的 DoH over HTTP/3(H3)

最初的技术直觉其实非常“正确”:

加密更安全、HTTP/3 更先进、TLS 更规范。

但现实使用的结论,和协议设计的“理想目标”,并不总是同一个方向。

UDP:最原始,但也是最“贴地气”的协议

在长期使用中,UDP 体现出的最大优势并不是“老”,而是:

✅ 建立连接零成本

✅ RTT 最短

✅ 延迟稳定

✅ 行为可预测

✅ 对缓存和并发极其友好

✅ 与 DNS的工作模型完全匹配

在真实网络环境下,UDP DNS 的优势非常现实:

国内解析:几乎总是最快

多并发解析:稳定、不抖动

缓存命中:路径极短

故障表现:要么成功,要么清晰失败

它最大的“缺点”只有一个:

“不加密”

但从使用角度看,在你已经完全控制上下游链路、本地递归与上游可信的前提下:

UDP 的“明文”并不会直接转化为“风险”,反而换来了最高的“可控性与可预测性”。

TCP:能用,但永远只是“兜底角色”

TCP DNS 在现实使用中的定位非常明确:

✅ 穿越性好

✅ 某些受限网络下成功率更高

❌ RTT 明显高于 UDP

❌ 并发能力差

❌ 不适合高频解析

在我的实际架构中,TCP 只承担一种角色:

“当 UDP 失败时的应急兜底通道”,而不是主力协议。

DoT:理论很优雅,使用上问题偏多

DoT 的设计初衷非常清晰:

加密

点对点

不依赖 HTTP

但长时间使用下来,它暴露出的问题也非常明显:

握手成本高

失败重试慢

- 被阻断

在部分运营商网络中稳定性不如 UDP + TCP 混合

节点质量一旦波动,恢复时间明显滞后

在高频 DNS 查询场景下,DoT 的“安全收益”并不能抵消它带来的:

整体响应变慢 + 不稳定放大效应

DoH:最“标准化”,也是最“重”的协议

DoH 的问题不在于技术是否先进,而在于它天生是一个:

“为 Web 世界设计的 DNS 承载方式”,而不是为“高频、低延迟解析”设计的。

实际体验中的几个明显问题:

明显高于 UDP 的延迟

HTTP 堆栈本身更重

在复杂网络环境下:

偶发阻断更隐蔽

故障更难快速定位

在浏览器内置场景中,DoH 是“隐私友好方案”;

但在你已经建立了本地可控 DNS 架构之后,它反而会变成:绕过你所有入口控制逻辑的“旁路通道”。

DoH over H3:概念先进,但当前阶段“不值得作为主力方案”

H3 的优势在于:

基于 QUIC

抗丢包

建连快

但在实际测试中,它的问题也非常现实:

节点质量高度不均

国内 IPv6 / UDP 路径极不稳定

某些网络环境下表现为:

假连接成功

实际数据迟迟不返回

在 DNS 这种对“确定性”要求极高的场景中,这类行为会直接放大故障排查复杂度。

最终结论:主力协议选 UDP,而不是“最先进的协议”

在长时间的真实使用之后,我最终得出的结论非常“反直觉”,但极其稳定:

✅ 主力协议:UDP

✅ 兜底协议:TCP

❌ DoT / DoH / H3:不作为主力,仅用于特定受限环境这并不是“保守”,而是一个很现实的工程判断:

在 DNS 这种“高频、低延迟、强确定性”的系统中,协议的“可预测性”永远比“加密层级”更优先。

解析策略最佳实践

在确定协议层以 UDP 为主之后,最终稳定下来的 DNS 规则体系,是这套“五层结构”:

✅ 第一层(国内规则)

国内域名 → 强制走本地宽带到国内公共 DNS → 优先返回同网运营商IP→ CDN优化测速 → 确保访问国内服务最快

这一层的目标非常单纯:

让所有“明确属于同网运营商或国内互联网”的东西,不被任何跨境逻辑干扰。

✅ 第二层(国外规则)

海外域名 → 强制走海外专线到海外公共 DNS → IXP优先返回最近CDN IP→ 优化测速 → 确保访问海外服务最近最稳

这一层解决的是:

不要让“出海流量”在国内互联网里兜圈子,也不要满世界绕路。

✅ 第三层(兜底规则)

未知域名 → 国内 + 海外公共 DNS 一起查询 → 全面测速 → 智能选择全局最优 IP

这是最关键的一层:

解决新域名

解决灰色域名

解决 CDN 调度不明确的域名

本质是:

用测速结果代替“预设立场”。

✅ 第四层(安全保障)

屏蔽广告、黄网、隐私跟踪、诈骗钓鱼、恶意域名,阻止数据收集和指纹识别

这一层不是“加速”,而是:

让 DNS 成为第一道“安全过滤器”。

✅ 第五层(恶意 IP 黑名单)

对解析出来的恶意 IP 集合应用“黑名单过滤”

也就是说:

就算某些恶意域名绕过了域名规则,只要它最终指向的是已知恶意 IP,例如银狐病毒,仍然会在出口前被拦下。

最终结论

在当前国内 + 跨境混合网络环境下,

最“先进”的 DNS 协议方案,往往不是最“好用”的;

而最“原始”的 UDP,反而是最稳定、最可控、最符合工程直觉的选择。这一整套:

UDP 主干

TCP 兜底

五层解析策略

多 DNS 并行测速

安全规则与 IP 黑名单叠加

本质上已经不是“DNS 优化方案”,而是一套:

✅ “现实网络环境下的 DNS 安全控制体系”

经验总结

通用规律 / 判断逻辑

DNS 决定的是“你站在哪个世界”

当我把运营商 DNS、公共 DNS、本地可控 DNS 全部放进同一个实测框架后,一个此前只是“感觉不对”的认知,终于变成了一个非常确定的结论:

DNS 从来不是“网络的配件”,而是“网络的入口定义器”。

你用什么 DNS,本质上不是在“选择一个解析服务”,而是在:

-

选择你站在哪个网络世界

-

选择你看到的是“国内互联网”,还是“真实互联网”

-

选择你后面的代理、路由、加速,到底是“在优化路径”,还是“在原地补救”

从工程角度看,我最终确认了几条在任何环境下都成立的判断逻辑:

① 只要 DNS 不可控,后面的一切“可控”都是伪命题

你可以:

-

写再复杂的策略路由

-

部署再高级的代理

-

叠再多层负载均衡

-

调再细的 TCP 参数

但只要:

DNS 返回的结果不是你“设计出来的”,

那你后面所有的控制都只是在“猜”。

这是我以前最大的工程错觉:

我以为我在“做网络控制”,

其实我只是在“对黑盒输出做补救”。

② 公共 DNS 解决的是“干净”,而不是“可控”

223.5.5.5、8.8.8.8 的意义在于:

-

它们比运营商 DNS 更“体面”

-

更少明目张胆的污染

-

更少赤裸裸的劫持

但它们依然是:

-

不透明的

-

不可审计的

-

不可预测的

-

不为你的业务目标服务的

也就是说:

公共 DNS 解决的是“伦理问题”,

但解决不了“企业业务控制问题”。

③ DNS 不是“被动响应”,而是“访问逻辑的第一层判断”

这一点,是我整个 DNS 认知升级中最重要的一次转变:

-

过去:

DNS = 查一个 IP

-

现在:

DNS = 决定“这类访问应该被送往哪个世界”

当你把 DNS 当成“第一层决策器”时:

-

国内 / 国外 / 应用服务的分界线前移了

-

灰色域名的处理前移了

-

流量属性的判定前移了

-

风险流量的处置也前移了

这意味着:

你不再是在“流量跑错之后再纠正它”,

而是在“它刚要起跑时就告诉它方向”。

风险预判

凡是出现这些现象,优先怀疑 DNS,而不是链路

在经历了这一整轮完整演进之后,我也逐渐形成了一套非常“反直觉”的故障优先级判断模型:

很多人一遇到网络异常,第一反应是:

线路问题

服务器问题

代理问题

而我的第一反应已经变成:

现在这是不是 DNS 在搞我?

凡是出现下面这些现象之一,我都会优先怀疑 DNS,而不是其他层:

✅ 1. 同一域名,不同设备结果完全不同

-

手机能用

-

电脑不能

-

公司能用

-

家里不行

这类问题,99% 不是“服务器歧视你”,

而是:

这些设备本来就在用“完全不同的 DNS 世界观”。

✅ 2. 不“彻底断网”,但长期“间歇性异常”

-

偶发超时

-

随机失败

-

白天正常,晚上失效

-

重启后恢复,一段时间后复发

这种行为最像的不是“故障”,而是:

解析路径在不同“区段之间来回跳跃”。

✅ 3. 你明明已经“固定走某条出口”,但效果却经常反着来

-

明明强制走代理

-

实际却经常回到直连

-

明明国内优先

-

实际却频繁绕海外

这通常意味着一件事:

你的“流量策略”是对的,

但你的“解析起点”是错的。

✅ 4. API、回调、WebSocket 这类“长连接型业务”异常最先暴露问题

这类业务对 DNS 的依赖极强:

-

首次解析错一次

-

后面所有重连都会跟错路径

所以:

当 API 抽风时,

请比平时更早一步怀疑 DNS。

小结:DNS 是你是否“真正控制网络”的分水岭

如果只用一句话总结这一整段 DNS 演进给我的最大经验,那就是:

你对 DNS 的态度,决定了你到底是在“使用网络”,

还是在“控制网络”。

-

使用网络的人:

-

只要能上网就满意

-

-

控制网络的人:

-

更在意“为什么能上”“是怎么能上”“还能不能稳定地上”

-

DNS,正是这两种人之间最清晰的一条分界线。

如果重来一次我会这样做

决策模型

这一整轮 DNS 的认知翻转与架构重构结束之后,我常常会反过来问自己一个问题:

如果一开始就站在今天的视角,我还会不会走那条弯路?

答案是:不会,但前提是我当时必须拥有现在这套判断模型。

如果重新来一次,我会从一开始就按下面这个顺序来做 DNS 相关决策。

决策模型:先控制入口,再谈路径优化

如果用一句工程化的话来概括,就是:

“先保证你走的是对的世界,再谈你在这个世界里走得快不快。”

具体拆开就是三步:

第一优先级:先控制 DNS,再部署代理和路由

我不会再做这种顺序:

-

先上代理

-

再配路由

-

最后随手丢一个 DNS 给系统用

而是会反过来:

-

✅ 先建立本地可控 DNS

-

✅ 把国内 / 国外 / 特殊域名在解析阶段就分干净

-

✅ 确认每一类域名“从一开始就被指向正确的世界”

-

✅ 最后再让路由去执行已经被“分流逻辑定型”的访问结果

这样做的最大意义在于:

后面所有策略都不再是“概率命中”,而是“前提正确”。

第二优先级:先保证“可解释”,再追求“极限性能”

如果重来一次,我不会再执着于:

-

哪个节点延迟最低

-

哪条链路带宽最大

-

哪个参数能榨出最后 5% 的性能

而会先确认一件更重要的事:

当问题发生时,我能不能解释清楚“它为什么会这样表现”?

如果一个网络结构是:

-

快

-

但行为不可预测

-

并且问题无法复现

那它在使用意义上就是不合格结构。

我现在更看重的是:

-

行为是否一致

-

路径是否稳定

-

故障是否可回溯

-

策略是否能被验证

第三优先级:先让系统“稳定正确”,再谈“智能”

我现在对“智能分流”“自动调度”这类词的态度非常谨慎。

如果重来一次,我会明确遵守一个原则:

在 DNS 上,所有“自动”,都必须建立在“你已经完全理解整个逻辑链”的前提之上。

否则“智能”很容易变成:

-

隐形决策

-

黑盒调度

-

无法审计

-

无法预测

也就是:

你以为“智能 / 自动”系统在“帮你优化”,实际上它在“做最有利于某些团体的决定”。

复盘认知升级

我真正意识到“网络不是工具,而是系统”

这一顿折腾下来,我最大的认知变化不在某一个软件、某一套配置,而在一个更底层的转变上:

-

过去我把网络当成:

-

工具

-

通道

-

基础设施

-

-

现在我把网络视为:

-

一个有输入、有决策、有反馈的系统

-

一个会“表达环境约束”的现实系统

-

一个必须被“建模、审计、验证”的复杂系统

-

而 DNS,正是这个系统里最容易被忽视,却最早影响一切判断的那一层。

未解决问题与后续演进

即便走到了现在这个节点,我也不会说 DNS 这件事“已经彻底解决了”。相反,它依然清楚地留下了几块我目前无法彻底绕开的现实问题。

当前不足

有些问题不是技术能单独解决的

有些情况不是技术能力问题,而是:

1.环境约束本身就不允许你“看到完整真相”。

你能做的更多是:

-

降低概率

-

提前识别

-

快速兜底

-

减少不确定性,而不是彻底消灭它。

2. 跨境路径的“现实不可控性”仍然存在

即使 DNS 给对了结果:

-

物理链路仍然可能抖动

-

国际出口仍然可能拥堵

-

云厂商的调度策略仍然会变化

DNS 只能保证你“站对世界”,但它不能保证你:

“在这个世界里永远畅通无阻。”

3. 公共服务每一次变化,都会反向影响 DNS 策略

很多 SaaS、CDN、云厂商都会:

-

不定期更换域名

-

不定期调整调度逻辑

-

不定期变更回源策略

这意味着:

DNS 策略不是“一次配置,永久生效”的系统,而是一个必须长期维护的演进工程。

未来方向

DNS 不再只是“解析层”,而是“网络策略中枢”

在我现在的架构规划里,DNS 的角色已经不再是:

-

单纯的解析服务

而是正在逐步演进为:

-

策略入口

-

风险筛选器

-

流量分类器

-

访问世界的“第一道门”

未来我真正感兴趣的方向只有三个:

1. DNS 与路由策略的深度联动

不再是:

-

DNS 只管解析

-

路由只管转发

而是形成:

“解析即策略,策略即路径”

的联动模型。

2. DNS 与安全系统的深度融合

让 DNS 不只是决定:

-

你去哪

还参与到:

-

你该不该去

-

你是不是异常流量

-

你是不是被劫持的访问

3. DNS 作为“网络可解释性”的入口层

最终目标不是“更快的 DNS”,

而是:

当网络行为变得异常时,你可以从 DNS 开始,一层一层解释清楚:

它为什么会变成现在这个样子。

未完

一切从 DNS 开始,不是因为它最底层,而是因为它最早参与了“选择”

DNS 不是网络里最“底层”的部分,

它是网络里最早参与“选择”的部分。

你选择了什么样的 DNS,

往往就已经决定了:

-

你会看到怎样的互联网

-

你会走上一条怎样的网络路径

-

你后面所有努力,到底是在“顺水行舟”,还是“逆流补偿”

也正因为如此,这篇文章才会取这样的标题:

《一切从 DNS 开始 | 当正常网络遇上墙管控》

不是因为 DNS 技术本身有多复杂,

而是因为:

你对 DNS 的态度,本质上决定了你对“网络可控性”的态度。

暂无评论,快来抢沙发吧!